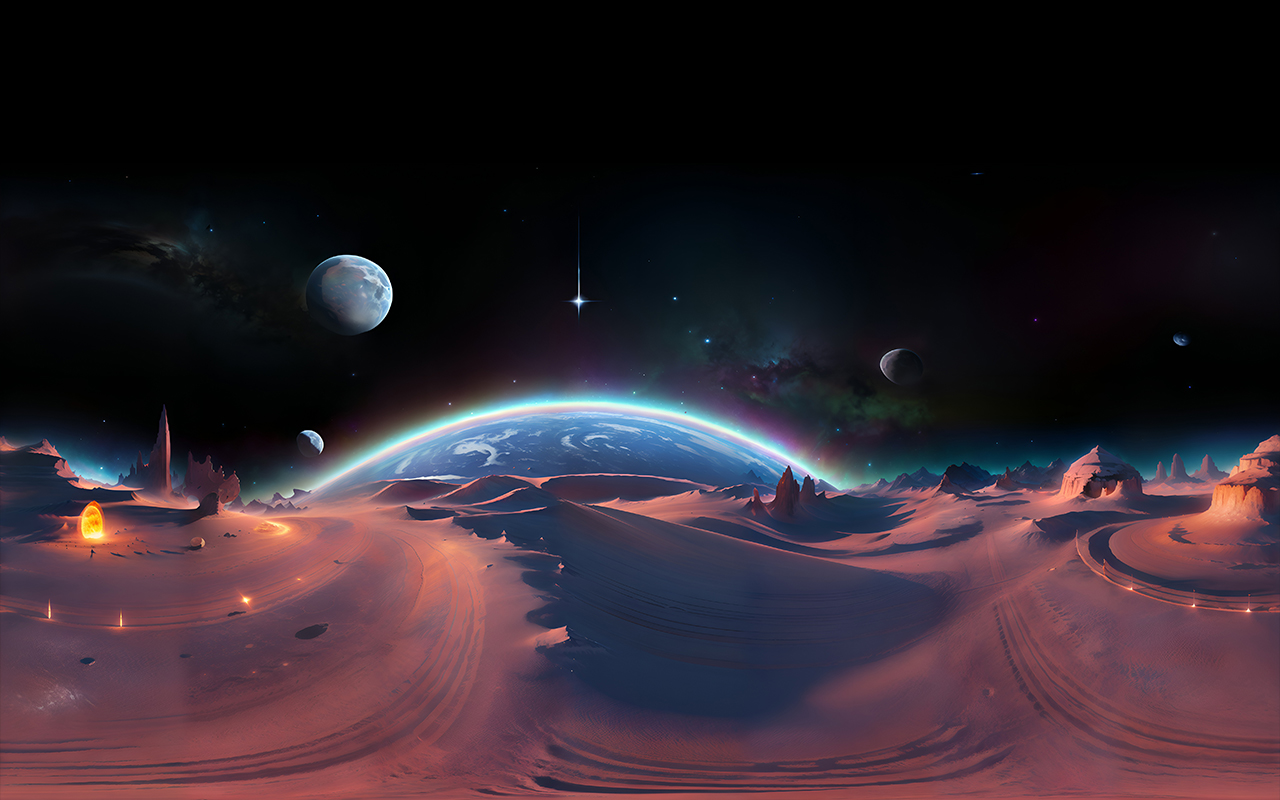

Esta experiencia visual y multimodal 360 se crea a través de la síntesis de imágenes en 2D y un panorama generado por IA para mostrar la misión CHAPEA (Crew Health and Performance Exploration Analog) de la NASA.

CHAPEA es una serie de misiones analógicas que simula una estancia de un año en la superficie de Marte. Esta misión consiste en cuatro miembros de la tripulación que viven en un hábitat impreso en 3D llamado 'Mars Dune Alpha' diseñado exclusivamente para replicar las condiciones realistas de Marte. El objetivo de la misión es recopilar los datos más precisos sobre la variedad de factores, incluida la salud física y conductual y el rendimiento. Se planea que CHAPEA conste de tres misiones analógicas. La primera misión comenzó el 25 de junio de 2023. La NASA a través de la misión CHAPEA crea un espacio físico pero también visual en forma de impresión 3D.

En esta pieza hemos querido exponer el proyecto CHAPEA mientras experimentábamos con el formato de interfaz del vídeo 360. Este vídeo 360 combina diferentes elementos: Inteligencia Artificial, sonificación de datos y secuencias de vídeo convencionales. Al combinar el panorama 360 con otros elementos, como un video informativo sobre el proyecto CHAPEA, buscamos encontrar distintas formas de narración visual y multimodal.

El video informativo 2D que se muestra en esta pieza 360 muestra el interior del hábitat espacial de la misión, que simula las condiciones de Marte, es decir, basado en datos astronómicos. El 360 aquí, que etiquetamos como "panorama especulativo generado por IA", se crea a través de Blockade Labs y Adobe Firefly AI generador de imágenes. El objetivo aquí era experimentar y explorar las capacidades y los límites del video 360 junto con el diseño generado por IA. Las indicaciones de texto utilizadas para crear este paisaje extraterrestre fueron:

"Espacio exterior" en estilo realista (para generar el paisaje 360)

"Coche de la misión Mars Rover"

"Colonia de campamento base espacial"

"Nave espacial alienígena"

"Hermoso espacio con nebulosa"

Aquí, los límites creativos de agregar y cambiar el entorno son infinitos, y se pueden agregar en diferentes capas mezclando sonido, imagen fija o videos. Por ejemplo,aunque el sonido de fondo podría parecer una banda sonora genérica de ciencia ficción, de hecho es la pieza de sonificación de datos de la NASA de los 5.000 exoplanetas que se incorpora a la experiencia. Esto asigna el trabajo de resultado para manejar diferentes capas sensoriales que se pueden combinar para generar experiencias multimodales. Posteriormente, la experiencia inmersiva creada para ser vista como VR, sostenemos, puede ser un medio de investigación multimodal. En esta pieza precisa, la investigación multimodal se inicia a través del contraste y la combinación del metraje documental como reflejo de la imagen y el diseño especulativo como reflejo de la imaginación.

En el futuro, planeamos trabajar más en estos panoramas generados por IA 360. Creemos que podrían ser una modalidad para crear una representación visual de los posibles escenarios en el contexto de las exploraciones astronómicas, y dentro de otras líneas de investigación del proyecto Visual Trust (Imágenes científicas, religiosas y sociales).

* Este resultado pertenece a la tarea 3.1 (Imágenes del espacio exterior y la estética científica), de la que es responsable la investigadora postdoctoral, Alkim Erol.

Referencias:

Adéntrate en el hábitat de simulación de Marte impreso en 3D de la NASA

5.000 exoplanetas: escucha los sonidos del descubrimiento (NASA Data Sonification)

https://www.srisathyasaiglobalcouncil.org/sri-sathya-sai-baba

Volver a la lista